Магнитно-резонансная томография в сочетании со стабильной диффузией удивительно точно воспроизводит просматриваемый человеком контент. Команда университетов Сингапура и Гонконга связала данные о мозговых волнах с ИИ для создания видеофайлов, которые показывают, что видел испытуемый в момент измерения.

Сначала Цзясинь Цин, Цзыцзяо Чен и Хуан Хелен Чжоу использовали набор данных из общедоступных видео и соответствующие сканы фМРТ. Те были затем переведены в данные и в сочетании с видеоматериалом применены для обучения собственной модели изображения AI Stable Diffusion.

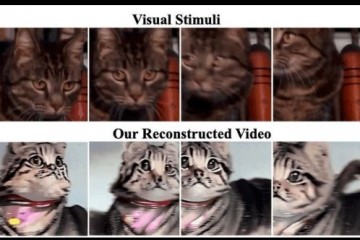

Для тестирования систему, названную MinD-Video, заставили генерировать видеоролики на основе данных фМРТ. Проверка содержания определила, что воспроизведенные ИИ видео показывают те же сцены, движения и предметы, что и просмотренные. Существенные отклонения наблюдаются в деталях и цветовой гамме.

По данным ученых, точность воспроизведения увиденного на видеофрагментах составила 85 %. Результаты исследования фиксируются и на специальном веб-сайте. Код для MinD-Video авторы планируют опубликовать на Github.

Исследователи считают полученный результат дополнительным доказательством того, что зрительная кора, фМРТ-данные которой были проанализированы, играет фундаментальную роль в зрительном восприятии и обрабатывает сигналы методом иерархической процедуры, который сначала анализирует структурную информацию, а затем переключается на визуальную и абстрактную.

Называя будущие области применения, исследователи приводят примеры использования соответствующей технологии в неврологии и устройствах, которые управляются сигналами мозга или передают электрические импульсы через имплантат на орган мышления (интерфейс мозг-компьютер).

Команда университетов Сингапура и Гонконга не первой применила подход, использованный в текущей работе. До нее с данными фМРТ и стабильной диффузией экспериментировали исследователи Университета Осаки, получившие на основе активности мозга точные неподвижные изображения высокого разрешения.