В течение полувека Джеффри Хинтон развивал технологию, лежащую в основе чат-ботов, таких как ChatGPT. Теперь он опасается, что это нанесет серьезный вред и что в одном отношении это страшнее ядерного оружия: межгосударственный контроль работы над ИИ невозможен.

Джеффри Хинтон был пионером искусственного интеллекта. В 2012 году доктор Хинтон и двое его аспирантов из Университета Торонто создали технологию, которая стала интеллектуальной основой для систем ИИ, которые крупнейшие компании технологической отрасли считают ключом к своему будущему.

Однако в понедельник он официально присоединился к растущему хору критиков, которые говорят, что эти компании мчатся навстречу опасности своей агрессивной кампанией по созданию продуктов на основе генеративного искусственного интеллекта, технологии, которая лежит в основе популярных чат-ботов, таких как ChatGPT.

Доктор Хинтон сказал, что уволился с работы в Гугле, где он проработал более десяти лет и стал одним из самых уважаемых людей в этой области, поэтому он может свободно говорить о рисках, связанных с искусственным интеллектом. Часть его, по его словам, теперь сожалеет о работе всей своей жизни.

«Я утешаю себя обычным оправданием: если бы я этого не сделал, это сделал бы кто-то другой», сказал доктор Хинтон во время продолжительного интервью на прошлой неделе в столовой своего дома в Торонто, в нескольких минутах ходьбы от того места, где он и его ученики совершили прорыв.

Путешествие доктора Хинтона от первооткрывателя ИИ до предсказателя гибели знаменует собой знаменательный момент для технологической отрасли, возможно, самый важный переломный момент за последние десятилетия. Лидеры отрасли считают, что новые системы ИИ могут иметь такое же важное значение, как появление веб-браузера в начале 1990-х годов, и могут привести к прорыву в различных областях, от исследования наркотиков до образования.

Но многих инсайдеров отрасли гложет страх, что они выпускают что-то опасное на волю. Генеративный ИИ уже может быть инструментом дезинформации. Вскоре это может стать угрозой для рабочих мест. Где-то в будущем, говорят самые большие пессимисты в области технологий, это может представлять опасность для человечества.

«Трудно понять, как вы можете помешать плохим людям использовать его для плохих целей», сказал доктор Хинтон.

После того, как в марте стартап OpenAI из Сан-Франциско выпустил новую версию ChatGPT, более 1000 технологических лидеров и исследователей подписали открытое письмо с призывом ввести шестимесячный мораторий на разработку новых систем, поскольку технологии ИИ представляют «глубокий риск для общества и человечества».

Несколько дней спустя 19 нынешних и бывших лидеров Ассоциации по развитию искусственного интеллекта, 40-летнего академического общества, опубликовали собственное письмо с предупреждением о рисках, связанных с искусственным интеллектом. В эту группу входил Эрик Хорвиц, главный научный сотрудник компании Майкрософт, которая внедрила технологию OpenAI в широкий спектр продуктов, включая поисковую систему Bing.

Доктор Хинтон, которого часто называют «крестным отцом ИИ», не подписал ни одно из этих писем и сказал, что не хочет публично критиковать Гугл или другие компании, пока не уволится с работы. В прошлом месяце он уведомил компанию о том, что уходит в отставку, а в четверг разговаривал по телефону с Сундаром Пичаи, исполнительным директором материнской компании Гугла, Alphabet. Он отказался публично обсуждать детали своего разговора с г-ном Пичаи.

Главный научный сотрудник Гугла Джефф Дин заявил: «Мы по-прежнему привержены ответственному подходу к ИИ. Мы постоянно учимся понимать возникающие риски, а также смело внедряем инновации».

Доктор Хинтон – 75-летний британский экспатриант, пожизненный академик, чья карьера была основана на его личных убеждениях в отношении разработки и использования ИИ. В 1972 году, будучи аспирантом Эдинбургского университета, доктор Хинтон увлекся идеей, названной нейронной сетью. Нейронная сеть – это математическая система, которая обучается навыкам путем анализа данных. В то время немногие исследователи верили в эту идею. Но это стало делом его жизни.

В 1980-х годах доктор Хинтон был профессором компьютерных наук в Университете Карнеги-Меллона, но уехал из университета в Канаду, потому что не хотел получать финансирование от Пентагона. В то время большинство исследований ИИ в США финансировались министерством обороны. Доктор Хинтон категорически против использования искусственного интеллекта на поле боя – того, что он называет «роботами-солдатами».

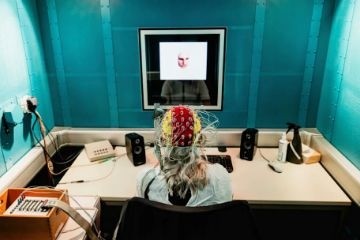

В 2012 году доктор Хинтон и двое его студентов в Торонто, Илья Суцкевер и Алекс Кришевский, построили нейронную сеть, которая могла анализировать тысячи фотографий и обучалась распознавать обычные объекты, такие как цветы, собаки и автомобили.

Гугл потратил $44 млн на приобретение компании, основанной доктором Хинтоном и двумя его студентами. И их система привела к созданию все более мощных технологий, включая новые чат-боты, такие как ChatGPT и Гугл Бард. Г-н Суцкевер стал главным научным сотрудником OpenAI. В 2018 году доктор Хинтон и два других давних сотрудника получили премию Тьюринга, которую часто называют «Нобелевской премией в области вычислительной техники», за свою работу над нейронными сетями.

Примерно в то же время Гугл, OpenAI и другие компании начали создавать нейронные сети, которые обучались на огромном количестве цифрового текста. Доктор Хинтон считал, что это мощный способ машин понимать и генерировать язык, но он уступает тому, как люди обращаются с языком.

Затем, в прошлом году, когда Гугл и OpenAI создавали системы, использующие гораздо большие объемы данных, его мнение изменилось. Он по-прежнему считал, что в некоторых отношениях эти системы уступают человеческому мозгу, но считал, что в других они затмевают человеческий разум. «Возможно, то, что происходит в этих системах, на самом деле намного лучше, чем то, что происходит в мозгу», сказал он.

По мере того, как компании совершенствуют свои системы ИИ, считает он, они становятся все более опасными: «Посмотрите, как это было пять лет назад и как сейчас. Возьмите разницу и распространите ее вперед. Это страшно».

По его словам, до прошлого года Гугл действовал как «хороший распорядитель» технологии, стараясь не выпускать что-то, что может причинить вред. Но теперь, когда Майкрософт дополнил свою поисковую систему Bing чат-ботом, что бросает вызов основному бизнесу Гугла, тот стремится внедрить такую же технологию. По словам доктора Хинтона, технологические гиганты вовлечены в конкуренцию, которую невозможно остановить.

Его непосредственная забота состоит в том, что интернет может оказаться наводненным фальшивыми фотографиями, видео и текстами, и обычный человек «больше не сможет знать, что правда».

Он также обеспокоен тем, что технологии ИИ со временем перевернут рынок труда. Сегодня чат-боты, такие как ChatGPT, как правило, дополняют людей, но они могут заменить помощников юристов, личных помощников, переводчиков и других, выполняющих рутинные задачи. «Это избавляет от рутинной работы», сказал он. «Но может забрать больше, чем это».

Он обеспокоен тем, что будущие версии технологии представляют угрозу для человечества, потому что они часто узнают о неожиданном поведении из огромного количества анализируемых данных. По его словам, это становится проблемой, поскольку отдельные лица и компании позволяют использовать системам ИИ не только генерировать собственный компьютерный код, но фактически запускать этот код самостоятельно. И он боится того дня, когда действительно автономное оружие – эти роботы-убийцы – станет реальностью.

«Идея о том, что эта штука действительно может стать умнее людей – в это поверили лишь немногие», сказал он. «Но большинство людей думали, что это далеко. И я думал, что далеко. Я думал, что это будет через 30-50 лет или даже больше. Очевидно, я больше так не думаю».

Многие другие эксперты, в том числе многие его ученики и коллеги, считают эту угрозу гипотетической. Но доктор Хинтон считает, что гонка между Гуглом, Майкрософтом и другими перерастет в глобальную, которая не остановится без какого-либо глобального же регулирования.

Но это может оказаться невозможным, сказал он. По его словам, в отличие от ядерного оружия, невозможно узнать, работают ли компании или страны в тайне над этой технологией. Лучше всего надеяться на то, что ведущие ученые мира будут сотрудничать в поиске способов управления технологией. «Я не думаю, что им следует расширять это, пока они не поймут, могут ли они это контролировать», сказал он.

Доктор Хинтон сказал, что, когда люди спрашивали его, как он может работать с потенциально опасной технологией, он перефразировал Роберта Оппенгеймера, руководившего усилиями США по созданию атомной бомбы: «Когда видишь что-то технически привлекательное, иди и сделай это».

Он больше так не говорит.