В пятницу в отелях Лас-Вегаса некоторые из самых мощных в мире систем искусственного интеллекта будут подвергнуты одновременной атаке со стороны небольшой армии хакеров, пытающихся найти их скрытые недостатки. Белый дом не только знает о готовящемся нападении, но и поддерживает его.

В мае администрация Байдена поддержала преднамеренную, скоординированную тестовую атаку на системы искусственного интеллекта, получившую название «красная команда», которая должна была разыграться в течение трех дней на ежегодном хакерском съезде в эти выходные. Несколько ведущих ИИ-компаний, в том числе OpenAI и Google, согласились на атаку своих новейших и самых мощных ИИ-систем.

Хакерская атака подчеркивает то, что стало одной из основных проблем Белого дома в отношении мощных, быстрорастущих новых моделей ИИ: насколько они на самом деле безопасны и могут ли они представлять угрозу для американских граждан или национальной безопасности в глобальном масштабе.

«Наша концепция, и это исходит от президента, заключается в том, что использования ИИ нам в первую очередь необходимо управлять рисками», сказал Алан Мислов, высокопоставленный сотрудник Управления научно-технической политики Белого дома, которое помогло организаторам хакерского соревнования разработать упражнения для красных команд на этих выходных. «Для таких вещей, как большие языковые модели, эти риски довольно велики, во многих случаях могут быть менее очевидными, чем другие системы», и «охватывают наше общество, нашу экономику, национальную безопасность», сказал Алан Мислов.

В то время как Конгресс изо всех сил пытается определить, какие новые законы принять об ИИ, а федеральные агентства используют свои существующие полномочия в отношении появляющейся технологии, Белый дом Байдена стал самым активным игроком в политике ИИ. Он разработал структуру Билля о правах ИИ, созвал руководителей технических компаний и провел серию пресс-конференций, посвященных широкому спектру угроз и возможностей, связанных с этой технологией.

Хотя эти угрозы варьируются, от потери работы до дискриминации и дезинформации, многие из наиболее ощутимых шагов Белого дома были сосредоточены на проблеме безопасности. Его новый специальный советник по ИИ Бен Бьюкенен имеет больше знаний в области национальной безопасности, чем технического образования. Когда в прошлом месяце Белый дом созвал лидеров ИИ, чтобы объявить о наборе добровольных обязательств, «безопасность» возглавила список и оказалась ключевой в документе.

Высокий приоритет безопасности отражает беспокойство экспертов, регулирующих органов и самой отрасли по поводу того, что сложные новые системы искусственного интеллекта представляют собой ряд новых проблем, которые до конца не изучены, от их способности быть взломанными и направленными по ложному пути злоумышленником до идеи о том, что они могут раскрывать пользовательские данные для более темных целей, таких как создание биологического оружия.

«Возможно заставить эти модели делать вещи, которые их дизайнеры и поставщики не ожидают или не хотят, чтобы они могли делать. Так что да, я думаю, что есть реальные соображения безопасности», сказал Арати Прабхакар, директор Управления науки и технологической политики Белого дома.

ИИ также может быть инструментом для повышения безопасности: на этой неделе Пентагон объявил о двухлетнем конкурсе для разработчиков на использование ИИ для усиления критической кибербезопасности Америки.

В эти выходные Белый дом заключил партнерское соглашение с AI Village на DEFCON, ежегодном съезде, на котором организаторы устраивают хакерские варгеймы, а специалисты по кибербезопасности раскрывают последние дыры в вездесущих технологиях. Правительственные учреждения, такие как Пентагон, уже обращались к хакерскому сообществу, чтобы найти уязвимости в кибербезопасности: в прошлом году на хакерском состязании DEFCON участник обнаружил выводящую из строя брешь в армейской электросети после того, как предоставил ей ложные данные о погоде.

Но версия этого года необычна как по уровню участия государства, так и по уровню участия отрасли. Компании в технологической отрасли традиционно неохотно выставляли проприетарное программное обеспечение на всеобщее обозрение для тестирования. Но в этом году по настоянию Белого дома технологические компании OpenAI, Anthropic, Google, Hugging Face, NVIDIA, Cohere и Stability предложили свои большие языковые модели для изучения.

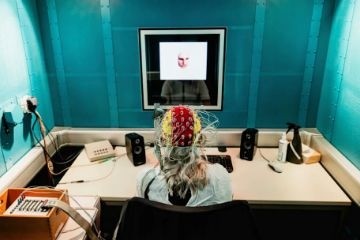

Они предоставят закрытые версии своих моделей для атаки со стороны целого ряда хакеров – от обычных опытных участников конференции до студентов муниципальных колледжей, прилетевших специально для этого испытания.

По словам Прабхакара из OSTP, идея участия Белого дома в учениях DEFCON родилась на предыдущей технической конференции: South by Southwest (SXSW) в Остине, штат Техас. После первой встречи на SXSW организаторы AI Village встретились с официальными лицами Белого дома, чтобы обсудить возможность расширения масштабов своей совместной работы на DEFCON и представления самых популярных на рынке больших языковых моделей. «Мы подумали, что это потрясающая идея, отличный способ посеять что-то действительно важное», сказал Прабхакар.

Фирмы согласились, хотя есть оговорка: результаты учений DEFCON Red Team не будут обнародованы до февраля, чтобы они могли до того исправить дыры или проблемы в безопасности. С ИИ процесс сложный. «Это не так просто, как простое исправление программного недостатка», сказал исследователь безопасности Крис Рольф.

Для промышленности ставки включают в себя завоевание общественного доверия к новой технологии, которая вызвала как тревогу, так и воодушевление. «Показывая, что эти модели проверены, мы создадим доверие сообщества в долгосрочной перспективе», сказал Рольф. Тем временем Майкл Селлитто, глава отдела геополитики и политики безопасности в Anthropic, надеется, что учения вызовут конкуренцию в области безопасности в самой технологической отрасли. «Одна из вещей, которую мы действительно хотим увидеть, это гонка за безопасностью», сказал он.

Несмотря на фанфары, само упражнение вряд ли раскроет все способы неправильного поведения систем ИИ, тем более что у каждого участника есть очень ограниченное время для взлома большой языковой модели (порядка 15 минут на попытку) и ограничения на техническое оборудование, доступное на мероприятии, сказал Селлитто из Anthropic.

Мислов, высокопоставленный чиновник Белого дома, участвующий в процессе планирования объединения красных, сказал, что администрация Байдена рассматривает это мероприятие DEFCON как модель на будущее. Отчасти она предназначена для того, чтобы найти наилучший способ проведения более крупномасштабных учений красных команд на ИИ. Цель Белого дома с DEFCON состоит в том, чтобы создать прецедент: «То, к чему мы хотим добраться, это будущее, в котором объединение красных команд широко практикуется многими сторонами», сказал Прабхакар.